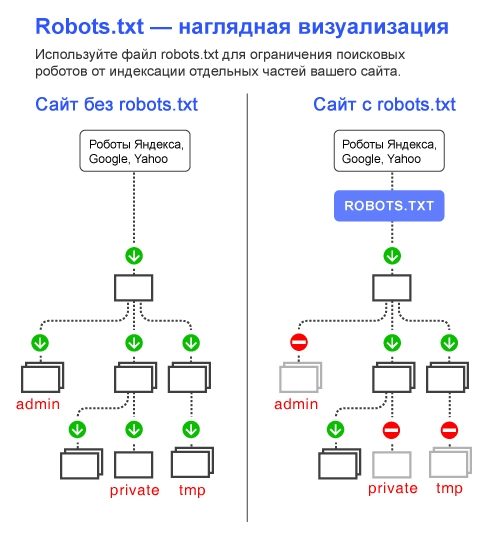

Robots.txt – текстовой файл, который сообщает поисковым роботам, какие файлы и папки следует сканировать (индексировать), а какие сканировать не нужно.

Поисковые системы, такие как Яндекс и Google сначала проверяют файл robots.txt, после этого начинают обход с помощью веб-роботов, которые занимаются архивированием и категоризацией веб сайтов.

Файл robots.txt содержит набор инструкций, которые просят бота игнорировать определенные файлы или каталоги. Это может быть сделано в целях конфиденциальности или потому что владелец сайта считает, что содержимое этих файлов и каталогов не должны появляться в выдаче поисковых систем.

Если веб-сайт имеет более одного субдомена, каждый субдомен должен иметь свой собственный файл robots.txt. Важно отметить, что не все боты будут использовать файл robots.txt. Некоторые злонамеренные боты даже читают файл robots.txt, чтобы найти, какие файлы и каталоги Вы хотели скрыть. Кроме того, даже если файл robots.txt указывает игнорировать определенные страницы на сайте, эти страницы могут по-прежнему появляться в результатах поиска, если на них ссылаются другие просканированные страницы. Стандартный роботс тхт для вордпресс открывает весь сайт для интдекса, поэтому нам нужно закрыть не нужные разделы WordPress от индексации.

Оптимальный robots.txt

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # системная папка на хостинге, закрывается всегда

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # запрос поиска

Disallow: *&s= # запрос поиска

Disallow: /search/ # запрос поиска

Disallow: /author/ # архив автора, если у Вас новостной блог с авторскими колонками, то можно открыть

# архив автора, если у Вас новостной блог с авторскими колонками, то можно открыть

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Host прописывать больше не нужно.Расширенный вариант (разделенные правила для Google и Яндекса)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

User-agent: GoogleBot # правила для Google (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д.

Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS

User-agent: Yandex # правила для Яндекса (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать

# от индексирования, а удалять параметры меток,

# Google такие правила не поддерживает

Clean-Param: openstat # аналогично

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Host прописывать больше не нужно.Оптимальный Robots.txt для WooCommerce

Владельцы интернет-магазинов на WordPress – WooCommerce также должны позаботиться о правильном robots.txt. Мы закроем от индексации корзину, страницу оформления заказа и ссылки на добавление товара в корзину.

User-agent: *

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Disallow: /cart/

Disallow: /checkout/

Disallow: /*add-to-cart=*

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Sitemap: https://site.ru/sitemap_index.xmlГде находится файл robots.txt в WordPress

Обычно robots.txt располагается в корне сайта. Если его нет, то потребуется создать текстовой файл и загрузить его на сайт по FTP или панель управления на хостинге. Если Вы не смогли найти robots.txt в корне сайта, но при переходе по ссылке вашсайт.ру/robots.txt он открывается, значит какой то из SEO плагинов сам генерирует его.

К примеру плагин Yoast SEO создает виртуальный файл, которого нет в корне сайта.

Как редактировать robots.txt с помощью Yoast SEO

- Зайдите в админ панель сайта

Админа панель находится по следующему адресу вашсайт.ру/wp-admin/

- Слева в консоли наведите на кнопку SEO и в выпадающем окне выберите “Инструменты”. Перейдите в раздел, как указано на картинке.

- Зайдите в редактор файлов

Этот инструмент позволит быстро отредактировать такие важные для вашего SEO файлы, как robots.txt и .htaccess (при его наличии).

- Если файла robots.txt нет, нажмите на кнопку создать, либо вставьте нужное содержимое.

Содержимое файла для WordPress и WooCommerce можно взять из примеров выше.

- Сохраните изменения в robots.txt

После сохранения файла вы можете проверить правильность через сервисы проверки.

Часто задаваемые вопросы

У Google и Яндекс есть средства для проверки файла robots.txt:

Яндекс – https://webmaster.yandex.ru/tools/robotstxt/

Google – https://support.google.com/webmasters/answer/6062598?hl=ru

По умолчанию мы рекомендуем закрывать feed от индексации в robots.txt. Открытие feed может потребоваться, если вы например настраиваете Турбо-страницы от Яндекса или выгружаете свою ленту в другой сервис.

Добавьте директиву: Allow: /feed/turbo/, тогда Яндекс сможет проверять ваши турбо-страницы и обновлять их.

Добавить комментарий

Вы должны зайти как в для комментирования записи